Die interne Verlinkung ist ein häufiges Sorgenkind. Bei fast allen Seiten. Nur selten gibt es zu wenige ausgehende Links, häufig jedoch viel zu viele. Unsere Empfehlung: Die interne Verlinkung optimieren und unnötige Links ausbauen. Aber bitte darauf achten, dass die richtigen Links drin bleiben…

Inzwischen gibt es zu diesem Thema auch regelmäßig Vorträge auf den einschlägigen SEO Konferenzen. Das zeigt, wie wichtig dieses Thema ist und welches Potential in einer optimierten internen Verlinkung steckt. Dieser Beitrag soll aufzeigen, welche Fehler gemacht werden und worauf man bei der internen Linkstruktur achten sollte.

Warum spielt die Anzahl ausgehender Links eine wichtige Rolle?

Jeder ausgehende Link transportiert sogenannten Linkjuice. Wie viel Linkjuice ein einzelner ausgehender Link transportiert, hängt im Wesentlichen von zwei Faktoren ab:

- Wie stark ist die linkgebende Seite selbst verlinkt? Also wie viele interne und externe Links zeigen auf die betrachtete Unterseite? In der Regel gilt: Die meiste Power hat die Startseite einer Website, weil es sich dabei um diejenige Unterseite handelt, die sowohl intern als auch extern die meisten Links erhält. Warum ist das so? Nun, weil die Startseite intern von jeder einzelnen Unterseite aus verlinkt wird. Außerdem wird bei externen Links, also Links auf eine „fremde“ Seite, häufig nicht auf eine spezielle Unterseite sondern direkt auf deren Startseite verlinkt. Die zweitstärksten Seiten befinden sich in der Regel auf der 1. Ebene. Dabei handelt es sich beispielsweise um Kategorieseiten, die zwar selten externe Links erhalten, jedoch intern sehr stark verlinkt sind (z. B. in der Navigation einer Website). Dementsprechend schwach auf der Brust sind folglich all diejenigen Unterseiten, die – von der Startseite aus gesehen – erst nach mehreren Klicks erreicht werden – also beispielsweise die Produktdetailseiten.

- Wie viele ausgehende Links sind auf der betrachteten Seite enthalten?

Grundsätzlich gilt also: Je schwächer eine Unterseite verlinkt ist, desto weniger Linkjuice steht dieser Seite zur Weitergabe zur Verfügung. Und, je mehr ausgehende Links auf einer Seite enthalten sind, desto weniger Linkjuice wird an jede einzelne, verlinkte Seite weitergegeben.

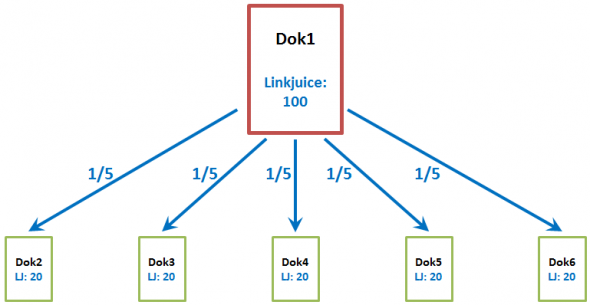

Beispiel für die Verteilung des Linkjuice: Steht einer Seite (in der Grafik mit „Dok1“ gekennzeichnet) ein fiktiver Linkjuice von 100 zur Verfügung und das Dokument verlinkt auf 5 Dokumente/Unterseiten, so erhält jedes dieser Dokumente 1/5 des Linkjuice von Dok1, also einen Linkjuice von 20.

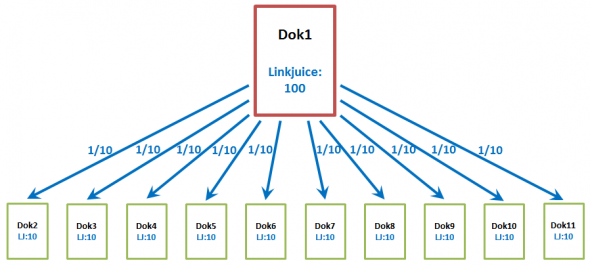

Beispiel Nr. 2: Verlinkt Dok1 hingegen auf 10 Unterseiten, so verteilt sich dessen Linkjuice nun auf die 10 verlinkten Dokumente. Jedes Dokument erhält nun also nur noch 1/10 des Linkjuice von Dok1, also einen Linkjuice von 10.

Bereits anhand dieser beiden sehr einfachen Beispiele wird deutlich, wie stark sich die Anzahl der ausgehenden Links auf die Durchblutung einer Website auswirkt.

Tipp Nr. 1: Nur relevante Links anzeigen – Siloing

Ziel sollte daher immer sein: Nur die wichtigsten bzw. relevanten Unterseiten verlinken. Diese können allerdings von Seite zu Seite variieren. Befindet sich der User eines Online-Shops beispielsweise auf der Produktdetailseite zum iPhone 5, so kann davon ausgegangen werden, dass ihn die Produktdetailseite des MacBook Air gerade nicht interessiert. Ein Link dorthin wäre folglich irrelevant für ihn und sollte dementsprechend gar nicht erst angezeigt werden. Da sich der User gerade ein hochwertiges Smartphone ansieht, könnte er allerdings Interesse an einem Samsung Galaxy S4 oder einem HTC One haben. Links zu diesen Seiten machen also durchaus Sinn. Ebenso ein Link auf die Kategorie „Smartphones“. Dem User – und natürlich auch dem Googlebot – sollten folglich nur diejenigen Links in der Navigation gezeigt werden, die auf der entsprechenden Unterseite relevant sind. Man spricht hierbei vom sogenannten Siloing. An dieser Stelle soll jedoch nicht näher darauf eingegangen werden. Wer sich für das Thema Siloing interessiert, dem empfehlen wir den äußerst ausführlichen Artikel auf bruceclay.com.

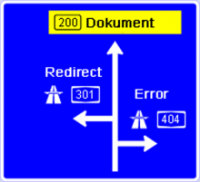

Tipp Nr. 2: Vermeide Links auf 404-Seiten oder 302-Weiterleitungen

Bei unseren Analysen stoßen wir immer wieder auf Websites, die in der Navigation, im Footer oder in der Randspalte jeder einzelnen Unterseite auf Seiten verlinken, die gar nicht mehr vorhanden sind oder mittlerweile via 30x-Redirect auf eine andere Seite weitergeleitet werden. Hier wird wertvoller Linkjuice verschwendet. Wir empfehlen regelmäßig die ausgehenden Links einzelner Seitenarten (Startseite, Kategorieseiten, Detailseiten etc.) zu überprüfen. Dabei sollten folgende Punkte beachtet werden:

- Links auf nicht mehr vorhandene Seiten (Statuscode 404, 410 etc.) sollten entweder entfernt oder repariert werden, da der Linkjuice ansonsten ins Leere fließt.

- Links auf Seiten, die via 302-Weiterleitung auf eine neue Zielseite weitergeleitet werden sollten ebenfalls korrigiert werden, also direkt auf die Zielseite abgeändert werden.

- Links auf Seiten, die via 301-Weiterleitung auf ein neues Ziel umgeleitet werden geben den Linkjuice zwar in der Regel an das neue Ziel weiter, dennoch ist es besser direkt die neue URL zu verlinken.

Tipp Nr. 3: Links auf Seiten die via Canonical-Tag auf eine andere Seite verweisen

Grundsätzlich gilt: Wird eine Seite verlinkt, sollte genau diese verlinkt werden und nicht eine Seite, die mit einem Canonical-Tag auf eine andere Seite zeigt. Erstens, weil man durch das Canonical-Tag auch ein bisschen Linkjuice verliert. Und zweitens führt das manchmal auch zu dem Ergebnis, dass Seiten gar nicht (also z.B. auch nicht in der Navigation) verlinkt werden – obwohl sie wichtig sind. Es zeigen immer nur Canonical-Tags darauf. Das macht aber keinen Sinn.

Deshalb schauen wir uns auch den Fluss des Linkjuices durch die Canonical-Brille an.

Doch es gibt noch einen zweiten, etwas schmutzigen Grund: In der Praxis stößt man immer wieder auf das Problem, dass man bestimmte Seiten gerne mit Linkjuice versorgen würde, sie allerdings nur ungern prominent (z. B. in der Hauptnavigation) verlinken möchte – das kann verschiedene, z. B. firmenpolitische Gründe haben. Als SEO löst man solche Probleme gerne durch den Einsatz von Canonical-Tags, indem man in der Navigation Seite A verlinkt, welche dann ein Canonical-Tag auf Seite B enthält. Durch den Einsatz des Canonical-Tags wird der Linkjuice, der auf Seite A auftrifft an Seite B weitergeleitet. Der Effekt ist also der gleiche wie beim Einsatz einer 301-Weiterleitung, allerdings mit dem Vorteil, dass der User davon nichts mitbekommt.

Dieser kleine Trick funktioniert derzeit noch recht gut und wird daher von vielen Kollegen praktiziert. Aus Sicht von Google handelt es sich dabei allerdings um einen Einsatz des Canonical-Tags, der nicht dessen eigentlichen Sinn entspricht. Denn der Inhalt der kanonisierten URL, also derjenigen URL, die im Canonical-Tag einer Seite angegeben wird, sollte identisch mit dem Inhalt der Seite sein, die eben dieses Canonical-Tag enthält. Google schreibt dazu:

Das Attribut

rel="canonical"sollte nur verwendet werden, um die bevorzugte Version mehrerer Seiten mit identischem Inhalt anzugeben (auch wenn kleinere Unterschiede wie die Sortierreihenfolge zulässig sind). Quelle: google.com

Aus diesem Grund prüfen wir auch Links, die auf Seiten verweisen, die ein abweichendes – also ein auf eine andere URL verweisendes – Canonical-Tag enthalten.

Tipp Nr. 4: Vermeide Links auf Seiten die via robots.txt oder Robots-Meta-Tag gesperrt sind

Ein weiterer Fehler, der häufig begangen wird, sind (zu viele) Links auf Seiten, die via robots.txt-Datei oder via Robots-Meta-Tag gesperrt sind. Natürlich lassen sich solche Links häufig nicht vermeiden, beispielsweise dann, wenn man ein WordPress-Blog betreibt und die Kategorien aufgrund mangelnden Unique Contents auf „noindex,follow“ gestellt hat. Hier geht der Linkjuice zwar nicht direkt verloren, da er zumindest von der angelinkten Seite an die darauf verlinkten Seiten weitergereicht wird, allerdings können mit der Seite selbst aufgrund des „noindex“-Attributs keine Rankings erzielt werden.

Gänzlich vermieden werden sollten Links auf Seiten, die via Robots-Meta-Tag auf „nofollow“ stehen, da der Linkjuice hier ebenfalls komplett ins Leere fließt. Gleiches gilt selbstverständlich auch für Links, welchen „nofollow“ direkt im rel-Attribut mitgegeben wird.

Tipp Nr. 5: Vermeide das Setzen mehrerer Links auf ein und dasselbe Linkziel

Häufig treffen wir auf Seiten, die mehrere Links auf ein und dasselbe Linkziel enthalten. Davon sind insbesondere Websites betroffen, die Produktdetailseiten anteasern und dabei das Artikelbild, die Überschrift, den Teaser-Text und häufig noch ein „weiterlesen“ oder ein „hier“ jeweils mit einem Link auf die entsprechende Produktdetailseite verlinken. Werden mehrere Produktdetailseiten angeteasert, kommt schnell eine nicht unbeachtliche Anzahl an Links zusammen und es wird viel Potential verschenkt, da Google jeweils nur den ersten Linktext auswertet.

Wir empfehlen solche Links zusammenzufassen. Das kann beispielsweise mit Hilfe von JavaScript und CSS erreicht werden.

Wie spürt man solche Links auf?

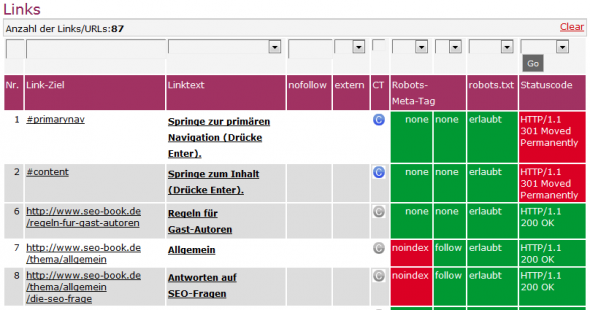

Wir bei der CONTENTmanufaktur verwenden dazu ein kleines eigens entwickeltes Tool, welchem wir eine URL übergeben. Das Tool überprüft dann alle auf der Seite gefundenen Links und liefert uns folgende Werte zurück:

- Ausgehende Links gesamt

- Externe ausgehende Links

- Anzahl nofollow-Links (Links die das rel=“nofollow“-Attribut tragen)

- Anzahl der Links auf Seiten die eine abweichende URL im Canonical-Tag tragen

- Anzahl der Links auf Seiten die via robots.txt-Datei gesperrt sind

- Anzahl der Links auf Seiten die via Robots-Meta-Tag auf „noindex“ oder „nofollow“ stehen

- Anzahl der Links auf Seiten die Statuscode „404 Not Found“ oder „410 Gone“ zurückliefern

- Anzahl der Links auf Seiten die via 301- oder 302-Redirect weitergeleitet werden

Mit Hilfe von Filtern lassen sich so schnell alle externen Links oder alle via robots.txt-Datei gesperrten Links auflisten.

Alle denen die CONTENTmanufaktur-Tools nicht zur Verfügung stehen, müssen sich mit Workarounds behelfen. Generell eignen sich Crawler wie der Screaming Frog SEO Spider oder Xenu’s Link Sleuth um solche Links aufzuspüren.

Auch strucr.com (mittlerweile audisto.com) bietet einige Möglichkeiten um an diese Daten heran zu kommen. Allerdings vermisse ich hier eine Liste, die mir alle ausgehenden Links einer Unterseite inkl. aller relevanter Daten (ähnlich dem Screenshot mit den ausgehenden Links in den CONTENTmanufaktur-Tools).

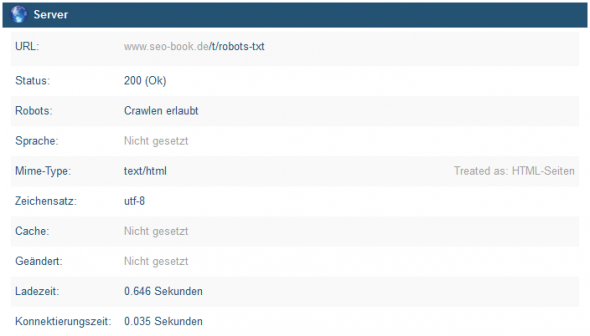

Seiten-Status in strucr.com

Auch die „großen“ SEO-Tools unterstützen bei der Optimierung der internen Verlinkung. So listet beispielsweise das Searchmetrics-Optimizer-Modul alle Seiten mit doppelten internen Linkzielen oder zu vielen externen Links auf. Und auch das Optimizer-Modul von Sistrix liefert Hinweise zu internen Weiterleitungen oder zeigt welche Inhalte nicht indexierbar sind. Aber auch bei diesen beiden Tools fehlt meiner Meinung nach eine übersichtliche Liste, die alle Links einer einzelnen Unterseite auflistet und eine genaue Analyse bzgl. der Optimierung der internen Verlinkung zulässt.

Am besten umgesetzt wird das derzeit von onpage.org (mittlerweile ryte.com). Hier ist es möglich sich alle Werte einer einzelnen URL anzusehen. Außerdem gibt es natürlich auch hier die Möglichkeit sich alle Seiten auflisten zu lassen, die via Robots-Meta-Tag gesperrt sind. Aber auch in onpage.org konnte ich leider keine Liste finden, die mir wirklich alle ausgehenden Links einer bestimmten URL inkl. der oben erwähnten Informationen anzeigt. Das wäre doch ein cooles neues Feature und würde super in das Tool passen, oder?

Update: Mittwoch,14. August 2013: Natürlich darf beim Thema interne Verlinkung das Tool von Thomas Zeithaml von der Seoratio GbR nicht fehlen. Ich habe mir das Tool erst kürzlich angesehen und hatte es selbstverständlich auch beim Schreiben dieses Artikels auf dem Plan. Allerdings war ich mir nicht sicher, ob es dem Tom Recht ist, wenn ich das Tool hier vorstelle, da es sich derzeit noch in der Beta-Phase befindet. Gerade eben traf jedoch sein Einverständnis ein. Deshalb hier noch ein kurzer Nachtrag.

Wer als Inhouse SEO oder als SEO-Agentur große Websites betreut und deren interne Verlinkung verbessern möchte, der sollte sich unbedingt die Seoratio Tools ansehen. Die Tools sind sehr umfangreich und bieten genügend Stoff für einen eigenen Artikel, weshalb wir an dieser Stelle auf eine ausführliche Vorstellung verzichten. Nicht unerwähnt bleiben sollte aber, dass die Jungs von Seoratio mit Hilfe des Tools den Fluss des Linkjuice auf den einzelnen Unterseiten berechnen. Ein echtes Expertentool also. Wir freuen uns schon auf das Release des Tools.

Update: Montag, 27. Dezember 2021: Mittlerweile wurden die Seoratio Tools leider eingestellt. 🙁

Mehr Tipps zum Thema interne Verlinkung:

- Die Folien zum SEO-Campixx-Vortrag „Die Macht der internen Verlinkung“ von Kai Spriestersbach und Thomas Zeithaml.

- Und hier noch ein schöner Grundlagen-Artikel zum Thema Interne Verlinkung von den SEO-Trainees.

- Last but not least: Der Grundlagen-Artikel von Hanns Kronenberg im Sistrix-Blog.