Die Welt des Online-Marketings und der Suchmaschinenoptimierung (SEO) entwickelt sich rasant. Mit dem Aufkommen fortschrittlicher Technologien wie ChatGPT von OpenAI stehen Marketern und SEO-Experten nun leistungsfähige Werkzeuge zur Verfügung, um ihre Websites effektiver und effizienter zu optimieren. In diesem Artikel will ich aufzeigen, wie dir ChatGPT bei der Überprüfung und Erstellung einer robots.txt-Datei helfen kann.

Was ist eine robots.txt-Datei?

Bevor wir eintauchen, ist es wichtig zu verstehen, was eine robots.txt-Datei ist. Es handelt sich um eine einfache Textdatei, die im Hauptverzeichnis einer Website platziert wird und Suchmaschinen-Crawlern Anweisungen gibt, welche Seiten sie auslesen dürfen und welche nicht.

Mit Hauptverzeichnis ist gemeint, dass die robots.txt-Datei über die Adressleiste des Browsers durch Anhängen von /robots.txt erreichbar sein muss.

Beispielsweise findest du die robots.txt-Datei dieser Seite unter https://www.seo-book.de/robots.txt.

So unterstützt dich ChatGPT bei der Überprüfung einer vorhandenen robots.txt-Datei

- Fehlererkennung: Bei der Erstellung einer robots.txt-Datei durch einen Mensch können schnell Leichtsinnsfehler gemacht werden. ChatGPT kann den Inhalt analysieren und gängige Fehler wie falsch formatierte Anweisungen oder fehlende User-Agent-Einträge identifizieren.

Beispiel:

Falsch:Disallow; /admin/

Richtig:Disallow: /admin/Bereits ein einfacher Syntaxfehler wie ein Semikolon statt eines Doppelpunkts kann den Eintrag ungültig machen. Mit Hilfe von ChatGPT kannst du solche Ungenauigkeiten schnell aufspüren. - Optimierungsvorschläge: Auf Basis des eingegebenen Inhalts kann ChatGPT Vorschläge zur Optimierung machen, z. B. die Verwendung von Wildcards, um Crawlern den Zugriff auf bestimmte Dateitypen zu verweigern.

Beispiel:

Um Crawlern den Zugriff auf alle PDF-Dateien einer Website zu verweigern:

Disallow: /*.pdf$

Beispiel

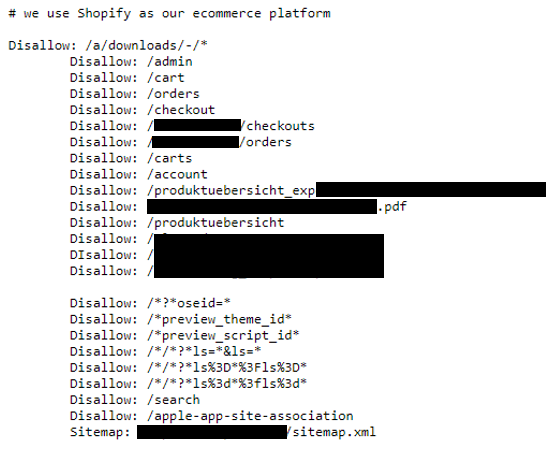

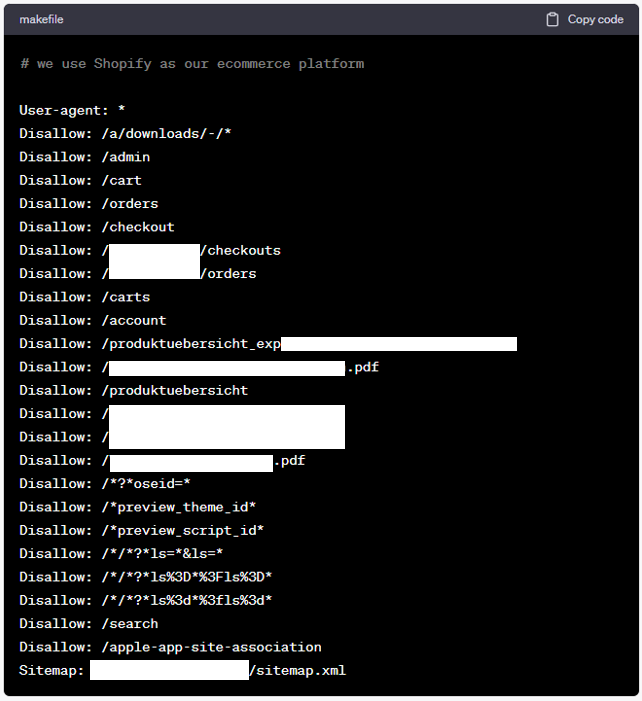

Im Rahmen einer Potentialanalyse haben wir vor wenigen Tagen beispielsweise folgende robots.txt-Datei vorgefunden:

Natürlich stechen einige Fehler sofort ins Auge:

- Fehlender `User-agent`: Es existiert keine „User-agent:“-Angabe. Stattdessen geht es direkt mit Disallow-Anweisungen los.

- Eingerückte `Disallow-Anweisungen`: Die Disallow-Anweisungen sind ab der zweiten Anweisung eingerückt.

- Leerzeile im Anweisungs-Block: Mittendrin wird der Anweisungsblock durch eine Leerzeile unterbrochen. (Hinweis: Erfahrungsgemäß kommt Google damit zurecht. Allerdings ist das syntaktisch nicht korrekt und sollte korrigiert werden, um sicherzustellen, dass alle Crawler mit der Anweisung zurecht kommen.)

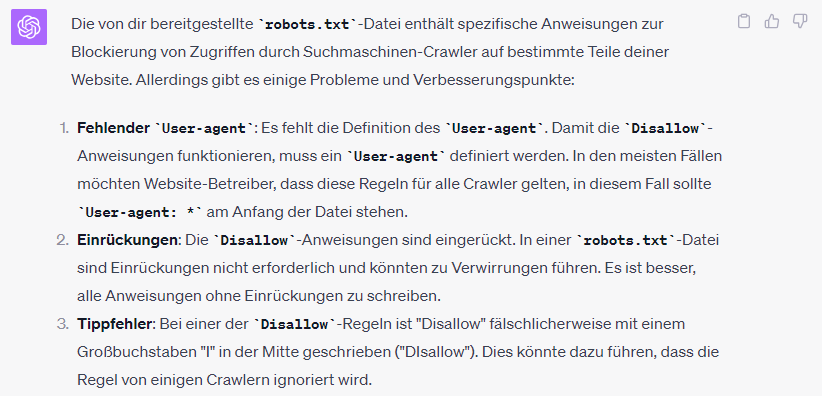

Werfen wir diese robots.txt-Datei in ChatGPT und bitten um Überprüfung der robots.txt-Datei auf Gültigkeit, so liefert ChatGTP uns folgende Antwort:

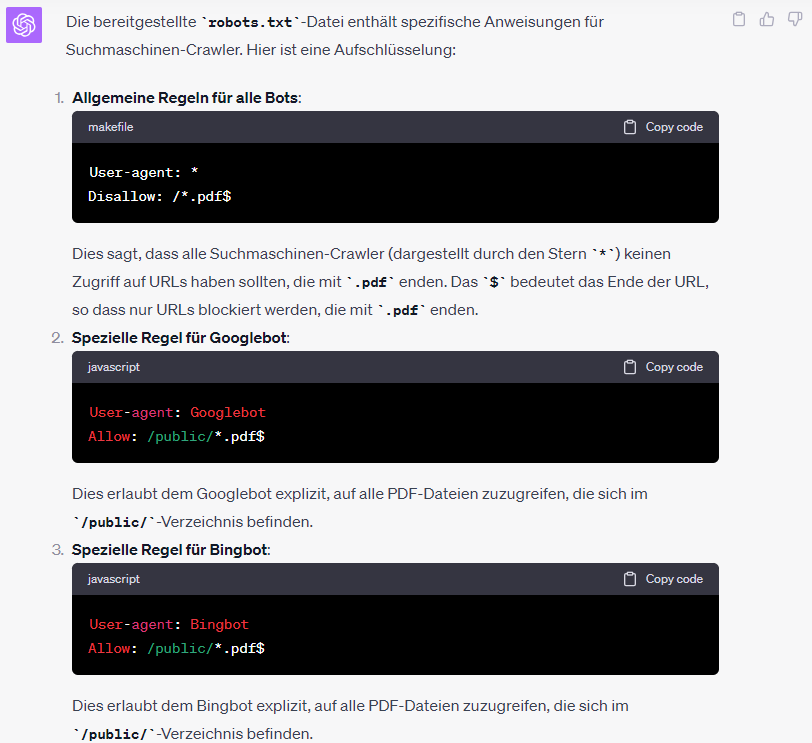

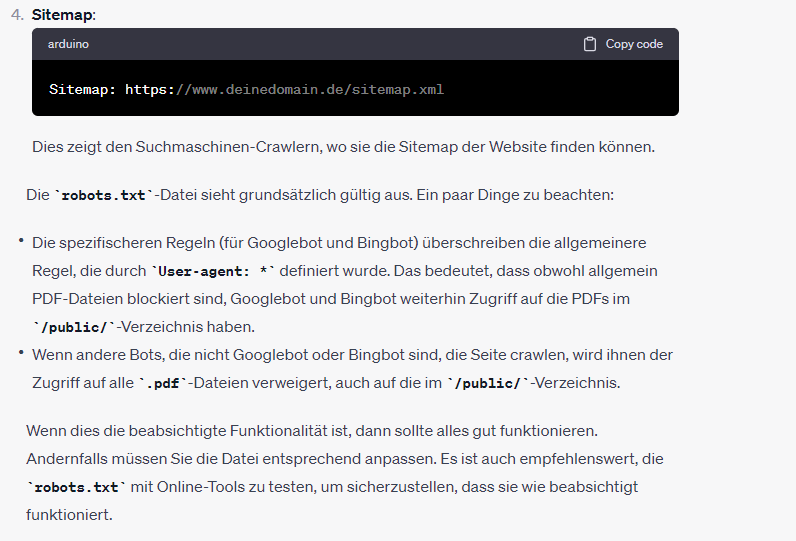

Die Fehler bzw. Verbesserungspunkte 1 und 2 lassen sich auch für einen geübten SEO bzw. Webentwickler schnell erkennen. Der Tippfehler in Punkt 3 hingegen ist schon deutlich schwerer zu erkennen. ChatGPT weist bereits daraufhin, dass dies dazu führen könnte, dass ChatGPT die Regel ignoriert. Auch hier ist es erfahrungsgemäß so, dass Crawler wie der Googlebot und andere Suchmaschinenbots mit solchen „Kleinigkeiten“ i. d. R. gut zu Recht kommen, da sie eine gewisse Fehlertoleranz im Umgang mit technischen Einstellungen wie der robots.txt-Datei an den Tag legen. Es kann allerdings nicht sichergestellt werden, dass die angesprochenen Crawler die Regeln dann auch wirklich berücksichtigen. Daher ist es ratsam, auch kleine Fehler, wie z. B. unnötige (fehlerhafte) Leerzeilen, Vertipper und andere Unachtsamkeiten zu korrigieren.

Hier noch die von ChatGPT optimierte robots.txt-Datei *

So unterstützt dich ChatGPT bei der Erstellung einer gültigen robots.txt-Datei

- Vorlagenerstellung: Anstatt von Grund auf neu zu beginnen, kannst du ChatGPT bitten, eine grundlegende robots.txt-Datei-Vorlage bereitzustellen, die du dann nach deinen spezifischen Anforderungen anpassen kannst.

- Individuelle Anforderungen: Basierend auf spezifischen Anforderungen oder Zielen, die du hast, kann ChatGPT maßgeschneiderte Anweisungen formulieren.

Beispiel:

Du möchtest, dass alle Unterseiten mit/test/im Pfad von Suchmaschinen-Crawlern ignoriert werden. ChatGPT könnte vorschlagen:

Disallow: /test/Beispiel

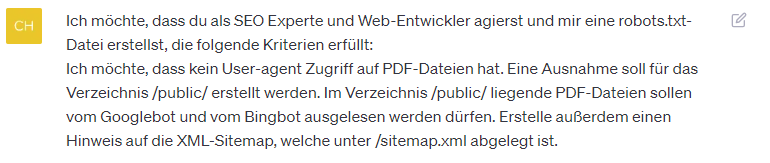

Ein gültiger Promt zur Erstellung einer robots.txt-Datei könnte beispielsweise wie folgt aussehen:

ChatGPT macht daraus dann folgendes:

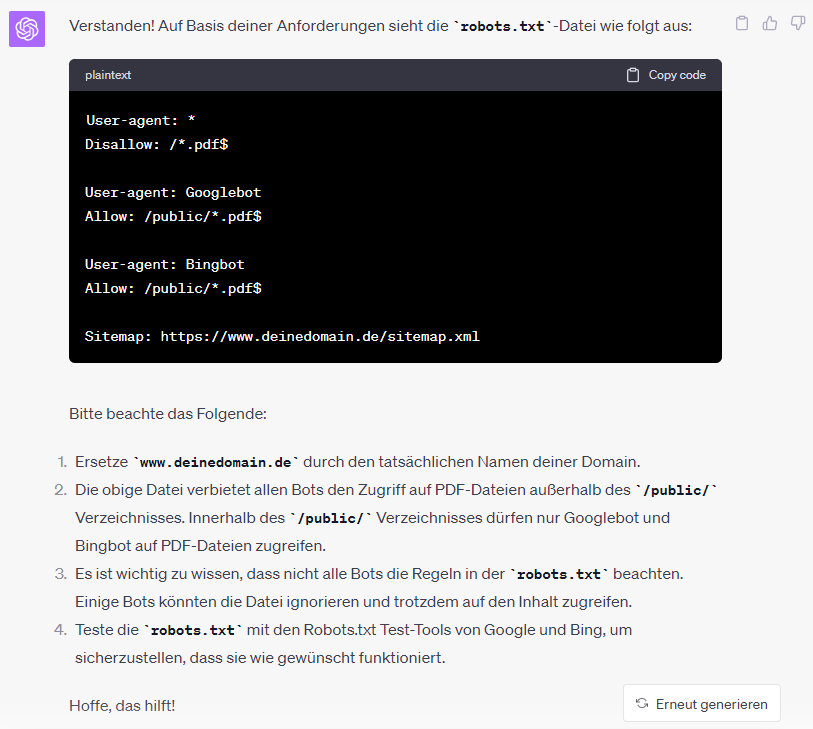

Gegenprobe: Überprüfung der robots.txt mittels ChatGPT

Selbstverständlich kannst du das Ergebnis im Anschluss in einem neuen Chat-Fenster von ChatGPT überprüfen lassen. Du erhältst dann folgendes Analyse-Ergebnis:

Disclaimer

Bitte bedenke, dass auch ChatGPT Fehler macht und in gewissen Situationen zu sogenannten Halluzinationen neigt. Du solltest also niemals blind auf die Ergebnisse von ChatGPT vertrauen. Insbesondere bei technischen Einstellungen, welche die Crawl- und Indexsteuerung deiner Website betreffen (z. B. robots.txt, .htaccess, etc. pp.) solltest du besonders vorsichtig sein und das Ergebnis in jedem Fall überprüfen.

* Wir haben die vorgeschlagenen robots.txt-Beispiele nicht getestet, da es sich teilweise um die Seiten von Kunden handelt und wir somit nicht ohne Weiteres die robots.txt austauschen und ausgiebig testen können.

ChatGPT Crawler sperren

Im Übrigen kann es Sinn machen ChatGPT die Nutzung (also das Crawlen und Auswerten) deiner Seite zu verbieten. Das erreichst du… natürlich mit einem Eintrag in der robots.txt-Datei. 😉

Beispiel-Code:

User-agent: GPTBot

Disallow: /Um einzelne Verzeichnisse zu sperren bzw. freizugeben, kannst du z. B. folgenden Code nutzen:

User-agent: GPTBot

Allow: /directory-1/

Disallow: /directory-2/Quelle: heise.deFazit

Technologien wie ChatGPT revolutionieren die Art und Weise, wie wir SEO-Aufgaben angehen. Durch die automatische Analyse und Generierung von robots.txt-Dateien können SEOs viel Zeit sparen und Fehler vermeiden, die sonst leicht übersehen werden könnten. Das Endziel bleibt jedoch dasselbe: eine Website zu schaffen, die sowohl für Benutzer als auch für Suchmaschinen optimiert ist. Mit den richtigen Werkzeugen an deiner Seite wird dieses Ziel umso schneller erreicht.

Buchempfehlung

Wenn du mehr über das Thema ChatGPT bzw. „Schreiben mit KI“ lernen möchtest, kann ich dir das Buch Richtig texten mit KI von meinem geschätzten Kollegen Kai Spriestersbach empfehlen.