Wer so lange im Geschäft ist wie wir, kennt sie: die unseriös arbeitenden Kollegen. Doch neben den schwarzen Schafen unter den SEO Agenturen gibt es auch viele andere Web-Arbeiter, die die drei Buchstaben einfach mal so in ihr Portfolio aufgenommen haben.

Suchmaschinenoptimierung? Ja klar, machen wir auch SEO.

Das ist häufig die Antwort von Webagenturen oder Webdesignern, wenn sich ein potentieller Kunde nach SEO erkundigt. Und es muss auch gar nicht schlimm sein, wenn Agenturen verstanden haben, dass SEO ein wichtiges Marketing-Instrument geworden ist. Sie informieren sich über die aktuellen Entwicklungen und schulen ihre Mitarbeiter in Sachen Suchmaschinenoptimierung. Prima.

Und, klar: Ein nicht zu unterschätzender Teil der Suchmaschinenoptimierung, nämlich die Onpage-Optimierung, wird bereits durch sauberes Handwerk abgedeckt. So kann die korrekte Verwendung von HTML-Auszeichnungen, das Beachten von Usability-Aspekten und das Aufsetzen einer gut durchdachten Informationsarchitektur bereits zu guten Ergebnissen führen. Und damit sollte sich ein Webentwickler eigentlich immer auseinander setzen, das kann bei kleinen Seiten bzw. weniger stark umkämpften Keywords bereits zu tollen Ergebnissen führen. Davon abgesehen schafft man damit eine solide Basis für spätere Linkbuilding-Maßnahmen.

Doch was hat das nun mit Abzocke und unseriösen Methoden zu tun? In den vergangenen Jahren mussten wir insbesondere im Umgang mit kleinen und mittelständischen Unternehmen immer wieder feststellen, dass manche Agenturen statt mit sauberem Handwerk leider mit vermeintlich wichtigen Buzzwords um sich werfen. Dabei handelt es sich oftmals um Methoden aus den Anfängen der Suchmaschinenoptimierung, die schon lange nicht mehr funktionieren oder noch nie funktioniert haben. Und das IST unseriös: Den Kunden mit altem, überholten Wissen so etwas wie Kompetenz vorzuspielen.

Einige dieser Methoden möchte ich vorstellen und mit den Gerüchten aufräumen.

Das Meta-Keywords-Tag

Leider auch 2013 noch anzutreffen ist die Masche mit den Meta-Keywords. Viele Agenturen haben noch immer nicht begriffen, dass dieses Meta-Tag kein Rankingfaktor bei Google ist. Einige argumentieren damit, dass es bei anderen Suchmaschinen wie Bing und Yahoo noch Einfluss auf das Ranking hätte. Die Marktanteile der genannten Suchmaschinen werden dabei jedoch meist nicht erwähnt.

Erst kürzlich hatten wir einen besonders krassen Fall, bei dem ein Entwickler sein System als besonders suchmaschinenfreundlich verkauft hatte und stolz darauf war, dass das CMS automatisch den Content der Unterseite analysiert und die am häufigsten vorkommenden Wörter als Suchbegriffe in den Meta-Keywords hinterlegt. WTF???

Vermutlich stirbt das Märchen mit den Meta-Keywords aber nie aus. Denn einfach eine Liste der relevanten Keywords auf der Seite zu hinterlegen, für welche man glaubt, gefunden werden zu wollen, erscheint dem Kunden plausibel. Das diese Art und Weise der „Optimierung“ schon im vergangenen Jahrtausend nicht mehr funktionierte, kann der Laie natürlich nicht wissen…

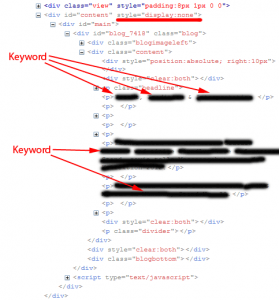

Wirklich böse: versteckter Text

Besonders „kreative“ Agenturen arbeiten gerne mal mit verstecktem Text. Dieser wird mit den wichtigsten Keywords vollgestopft versehen und natürlich farblich an den Hintergrund der Seite angepasst. Also weiße Schrift auf weißem Hintergrund. Oder bei schwarzem Hintergrund auch gerne mal in einem sehr dunklen Grau, damit es nicht zu sehr auffällt. Die richtig Kreativen verwenden auch gerne mal CSS und display=“none“; um den Text einfach auszublenden. Oder der Text wird um 1000 Pixel nach links aus dem sichtbaren Bereich verschoben.

Wer jetzt denkt: „Das wurde vielleicht früher mal so gemacht, dass findet man heutzutage doch so nicht mehr.“ Der täuscht sich leider. Wir hatten erst letzte Woche einen solchen Fall!

Umso entsetzter sind die Blicke der Kunden dann, wenn man ihnen mitteilt, dass dies ein klarer Verstoß gegen die Google Webmaster Richtlinien ist, der zudem noch relativ leicht erkannt werden kann und zu harten Strafen führt. Mehr zum Thema verborgener Text direkt bei Google.

Der Klassiker: Relaunch ohne Weiterleitungen

Nicht böse aber schrecklick ungklücklich: Der wahrscheinlich häufigste Fehler, der von Webagenturen gemacht wird, ist das Problem mit den vergessenen Weiterleitungen. Wochen- oder sogar monatelang werden Designentwürfe erstellt und mit dem Kunden abgesprochen. Jedes Pixel wird x-mal hin und her geschubst. Irgendwann wird dann auch über die neue URL-Struktur diskutiert. Die vielleicht sogar „Speaking URLs“ vorsieht („Wir können SEO!“). Was dabei jedoch häufig – auch von wirklich großen Agenturen und bei wirklich großen Kunden – vergessen wird: die 301-Weiterleitungen der alten Seiten auf die entsprechenden neuen Seiten. Das Problem dabei ist, dass der Kunde dadurch oftmals seine kompletten Rankings verliert. Bei sehr kleinen Kunden fällt das oft auch gar nicht auf, weil dort die Startseite für die wichtigsten Begriffe rankt und deren URL sich nicht ändert.

Relaunch ohne 301er: Sichtbarkeit erholt sich auch nach Monaten nicht

Weiterleitungen der Bilder

Ein weiterer, beliebter Fehler: Es wird zwar an die Weiterleitungen der HTML-Seiten, nicht aber an die der Bilder gedacht. Fatal ist das vor allem dann, wenn der Kunde Rankings in der Google Bildersuche vorzuweisen hatte. Denn das wird meist erst dann bemerkt, wenn darüber kein Traffic mehr kommt bzw. der Kunde die ihm bekannten Keywords in der Bildersuche eingibt und seine Bilder sucht, die noch vor wenigen Wochen so gut zu finden waren. Und dann ist es zu spät. Besonders hart davon betroffen sind häufig auch Künstler und Fotografen, bei welchen Bilder oft einen großen Teil der Rankings ausmachen. Übrigens: In unserem SEOkomm Recap gibt es noch etwas mehr Informationen zum Thema Relaunch ohne Weiterleitungen.

Duplicate Content

Auch das Thema Duplicate Content scheint bei vielen Webagenturen noch nicht angekommen zu sein bzw. unterschätzt zu werden. Immer wieder trifft man auf Webseiten, deren Startseiten-Content unter X unterschiedlichen URLs erreichbar ist. Häufig sind dynamische URLs, also URLs mit Parametern die Ursache dafür. Oder die immergleichen Inhalte werden fleißig auf viele Seiten verteilt. „Weil man doch überall Content haben muss. Aber wer soll das denn alles schreiben?“

Dynamische URLs und das Canonical-Tag

Gelöst werden kann dieses Problem mit Hilfe des Canonical-Tags. Dazu sollte auf allen URLs, die einen Parameter enthalten, ein Canonical-Tag gesetzt werden. Dieses sollte die jeweilige URL ohne Parameter enthalten und Google somit einen Hinweis auf die korrekte URL für den entsprechenden Content geben. Noch besser wäre es natürlich gänzlich auf dynamische URLs zu verzichten.

Fehlende kanonische Weiterleitungen

Auch das Fehlen sogenannter kanonischer Weiterleitungen ist eine häufige Ursache für Duplicate Content. Damit ist gemeint, dass keine bevorzugte Domain (http://www.domain.de bzw. http://domain.de) exisitiert, auf die alle abweichenden Anfragen weitergeleitet werden.

Ein Beispiel für eine kanonische Weiterleitungen:

Die internen Links der Website zeigen alle auf URLs mit Subdomain (z. B. http://www.domain.de). In der Sitemap werden die URLs jedoch ohne Subdomain (also z. B. so http://domain.de) angegeben. Dadurch gelangen alle Inhalte unter zwei unterschiedlichen URLs in den Index, was von Google als Duplicate Content gewertet wird.

Dieses Problem kann mit äußerst geringem Aufwand behoben werden: ein Eintrag in der .htaccess-Datei sorgt für die gewünschte Weiterleitung aller Unterseiten auf die jeweils korrekte Variante. Der entsprechende Eintrag für die .htaccess-Datei findet sich im Beitrag über die .htaccess-Datei von Hubert: Richtigen Host erzwingen. (Beitrag ist leider offline.)

Zusätzlich sollte die bevorzugte Domain in den Google Webmaster Tools hinterlegt werden.

Das ewige Märchen vom PageRank

Ebenfalls noch weit verbreitet ist das Märchen vom PageRank. Leider steckt in diesem nun mal das Wort „Rank“, was viele mit dem Begriff „Ranking“ verbinden. Immer wieder trifft man auf Seitenbetreiber, die sich Sorgen um ihre Rankings machen, weil ihre Seite einen „schlechten“ PageRank vorzuweisen hat. Das Bizarre daran ist, dass es Agenturen gibt, die die gute Arbeit ihrer Konkurrenten schlecht reden, indem sie den Kunden auf ihren schlechten PageRank ansprechen. Leider haben wir bereits mehrfach mitbekommen, dass diese vermeintliche KPI dem Kunden nicht erklärt wird. So heißt es dann beispielsweise:

„Desweiteren hat die alte Seite, trotz einem „SEO Profi“ einen PageRank von 0 erzielt und ein Backlink und Alexa Ranking jenseits von Gut und Böse.“

Nicht selten wird der Kunde durch solche Aussagen komplett verunsichert und fühlt sich von seinem SEO über’s Ohr gezogen. Und das obwohl seine Seite für alle ihm wichtigen Begriffe auf dem ersten Platz gefunden wird.

Update: Wer vor dem Problem steht, einen Kunden zum Thema PageRank aufklären zu müssen, dem sei der Artikel Google PageRank Mythos aufgedeckt von Vladislav Melnik empfohlen.

Ob es sich bei solchen Aussagen um böswillige Absicht oder einfach „nur“ um Unwissenheit handelt, ist vermutlich mal so und mal so. Fest steht jedoch, dass Halbwissen in der Kundenberatung keinen Platz haben sollte. Und dazu gehört eben auch, dass vermeintliche KPIs bzw. Kennzahlen und deren Aussagekraft entweder ausreichend erklärt werden müssen – oder man sollte sie gar nicht erwähnen.

Und wer jetzt noch nicht genug vom Thema SEO Mythen hat, der kann bei Björn Tantau direkt weiterlesen.

Fazit

Leider scheint es auch 2013 noch eine Menge Schwarze Schafe zu geben, die ihre Kunden aufgrund gefährlichen Halbwissens falsch beraten oder sogar absichtlich versuchen zu täuschen. Wir sollten daher unser Bestes geben, um auch kleinste Kunden umfangreich aufzuklären. Das erreichen wir in erster Linie durch einen fairen Umgang auf Augenhöhe und einem möglichst hohen Maß an Transparenz. Kennzahlen sollten dem Kunden erklärt werden und Optimierungsvorschläge sollten „State of the Art“ sein.

Na klar, das ist nicht einfach. Aber es hat auch keiner gesagt, dass SEO einfach ist. Und, hey: Wir schreiben uns ja auch nicht schnell mal „Webdesign“ oder „Webentwicklung“ ins Portfolio…